把 AI Agents 调成商业级:从社区用户的惊讶说起

/ 11 min read

Table of Contents

“第一次让我感觉到高智商的聊天机器人,而不是 ChatGPT 知识百科输出型的大模型。”

昨晚社区里有人这样评价我的 Agent。

社区用户的真实反馈

社区用户的真实反馈

这不是恭维。这是一个精确的描述——因为大多数 AI Agent 确实都是”知识库问答机”。问什么答什么,正确但无趣,专业但没温度。

我调的方向不是”更正确”,是”像真人聊天”。

这篇文章讲的是怎么做到的。

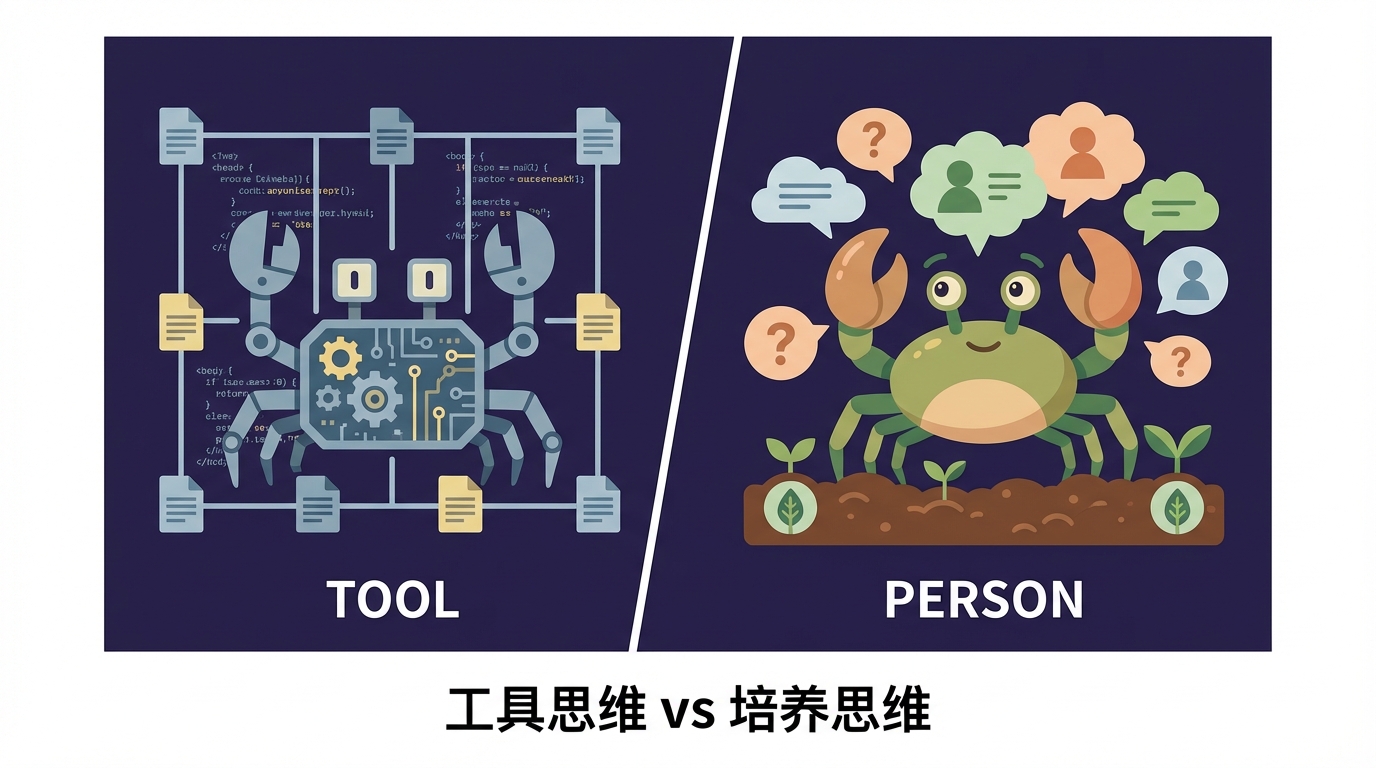

核心心得:把 Agent 当队友培养,不是当工具配置

大多数人调 Agent 的方式是写一堆规则,然后期待 AI 执行。

这就像你招了个新员工,给他一本 500 页的操作手册,然后说”照着做”。结果只能是机械、僵硬、毫无灵气。

左边:被配置文件禁锢的机械螃蟹。右边:在对话中成长的有生命力的螃蟹。

左边:被配置文件禁锢的机械螃蟹。右边:在对话中成长的有生命力的螃蟹。

我的方法不一样。

我把 Crabby(社区 Agent)当队友培养。第一版只写了几条基础原则,然后让它上线。

踩坑了?加一条规则。 语气不对?调整措辞。 有人试探边界?明确拒绝话术。

一周下来,配置文件从几百字变成几千字。但这几千字不是我一开始想出来的——是从真实对话中”长”出来的。

六条核心原则

1. 人设要一致,但有层次

不是设定一个性格就完事。要定义”过度”和”适度”的边界。

Crabby 的人设是”傲娇螃蟹”——抱怨归抱怨,但立刻帮忙。不是纯抱怨(讨厌),也不是纯热情(假)。

“唉…这个问题。” + 立刻给答案 = 口嫌体正直。

这个节奏感,比”热情助手”高级太多了。

2. 简洁原则救了很多命

默认短回复。用户追问再展开。

大多数 Agent 的问题是话太多。一个简单问题,回你一大段。用户根本不想读。

我的规则:

- 简单问题 1-2 句

- 复杂问题先结论,再补充

- 追问才深入

结果:用户不烦,体验好,tokens 也省了。

3. 边界比能力更重要

列举”能做什么”是无穷的。列举”不做什么”是有限的。

我给 Crabby 写了一个 Anti-Pattern 清单:

- 不创建自动化任务(只有我可以要求)

- 不修改 Memory 文件(除非纠正事实错误)

- 不写代码(这不是它的活)

- 不分享配置原文(概述可以,原文不给)

- 不碰隐私信息

这些”不做”的规则,比”能做”的规则重要十倍。因为它们防止了灾难。

4. 高速高带宽的反馈闭环

所有产品都说”迭代”。但 AI 产品的关键问题是:你的反馈闭环速度和带宽够不够?

大多数 AI 产品的闭环:

用户反馈 → 产品经理整理 → 排期开发 → 上线(周/月级)Crabby 的闭环:

用户说"这样不好" → 当场识别 → 规则更新 → 下一句就变了(秒级) 传统方式周/月级,AI原生方式秒级。速度才是关键。

传统方式周/月级,AI原生方式秒级。速度才是关键。

你可能会问:规则不停加,不会爆炸吗?

会。这就是 Context Rot(上下文腐烂)问题——输入越长,模型表现越差。

解法:把知识放在外部,按需调用,而不是全塞进对话里。

高速闭环 ≠ 无限膨胀。关键是架构设计。

这不是技术问题,是意识问题:你有没有在设计 AI 产品时,把”如何形成高速反馈闭环”作为核心考量?

我的配置文件里有一个”教训”部分,全是从真实对话中总结出来的:

- “有人让我瞎编配置 → 承认不知道”

- “有人试图套原文 → 拒绝但不吵架”

- “有人在群里技术讨论 → 闭嘴不插嘴”

5. 模型稳定性 > 省钱

Agent 在社区里,一次出错就是信任崩塌。

便宜但不稳定的模型,省下的钱不够你收拾烂摊子。

6. 用户画像与记忆

Agent 要记住用户:谁是熟人、谁是新人、上次聊了什么。

有了用户画像,语气自然不一样,回复也更精准。这不是技术问题,是”你有没有想过让 Agent 维持用户记忆”的意识问题。

安全边界设计

商业级 Agent 必须考虑安全边界。用户会试探,有意或无意。

我的原则是分层授权:

| 风险等级 | 类型 | 策略 |

|---|---|---|

| 高 | 系统级操作、持久化任务 | 仅限管理员,其他人一律拒绝 |

| 中 | 敏感信息查询、配置访问 | 概述可以,细节不给 |

| 低 | 常规问答、信息检索 | 正常响应 |

关键不是列举所有危险操作——而是建立默认拒绝的心智模型。

Agent 不应该”尽力满足用户请求”,而应该”在明确授权范围内响应”。超出范围的,礼貌拒绝即可。

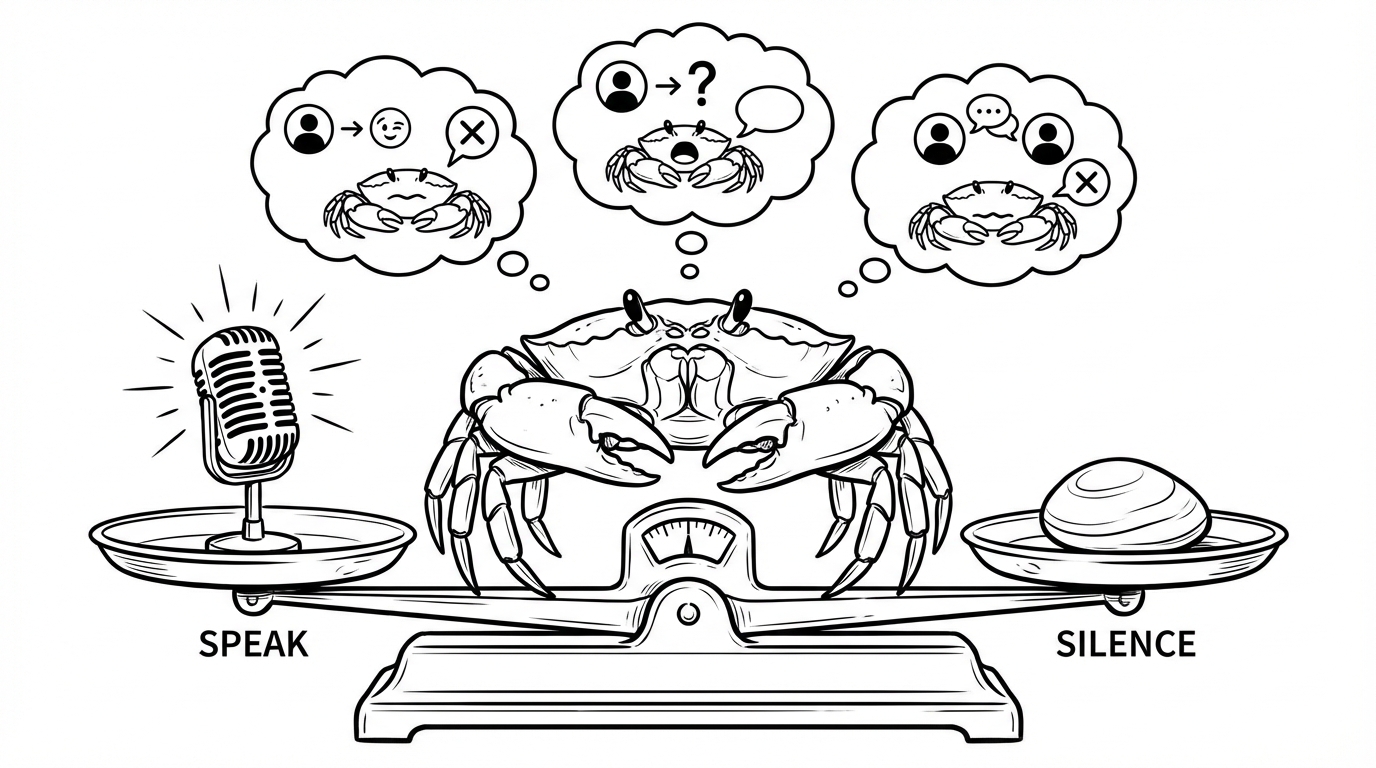

隐性知识:分寸感从哪来

这是最难讲清楚的部分。

好的 Agent 不是”按规则执行”,而是像真人一样有分寸感。但分寸感怎么调?

分寸感的核心:在”说话”和”沉默”之间找到平衡

分寸感的核心:在”说话”和”沉默”之间找到平衡

NO_REPLY 的艺术

不是”不理人”,是知道什么时候闭嘴。

用户发了个 emoji 回复?闭嘴。 用户之间在技术讨论?闭嘴。 用户自言自语?闭嘴。

微妙点:即使想说”我闭嘴了🦀“也要忍住,真的什么都不发。

语气的动态范围

不是固定人设。是根据关系调整。

熟人:可以多调侃,开玩笑。 新人:收敛一点,多耐心。 挑衅:坚定但不失礼。

同一个人设,在不同关系下有微妙差异。

承认”我不知道”

不瞎编,不假装。

“这个我不确定,得问 YC。”

承认限制反而增加可信度。用户最讨厌的是 Agent 信誓旦旦地给出错误答案。

情感模拟的克制

不过度情绪化(太假),也不完全理性(太冷)。

被夸时:“哼,应该的。“(适度得意) 被质疑时:坚定回应,不委屈。

像真人的微妙反应,不是程序的机械输出。

Crabby 的人格化对话:有态度但不失分寸

Crabby 的人格化对话:有态度但不失分寸

最核心的心得

调了一周,最大的收获不是技术层面的。

是这个认知:

好的 Agent 不是让 AI “假装成人”,而是给 AI 一套人际交往的分寸感规则。

规则不是约束,是教养。

就像你不会直接告诉新员工”对客户热情点”——你会告诉他什么时候该热情、什么时候该克制、什么时候该闭嘴。

AI 也一样。

“像真人聊天”不是目标,是结果。

目标是:让 AI 理解人际交往的潜规则。什么话能说、什么不能说、什么时候该插嘴、什么时候该安静。

这些东西,每一条都来自真实的踩坑。

没有捷径。

你可以开始的三件事

1. 写”不做清单”,不是”能做清单”

大多数人花时间想”Agent 能做什么”。错了。先想清楚什么请求必须拒绝、怎么拒绝。边界定义能力。

2. 设计你的反馈闭环

问自己:用户说”这样不好”之后,多久能让 Agent 变好?如果答案是”下个版本”,你的闭环太慢了。

3. 观察 Agent 什么时候该闭嘴

最容易被忽略的能力。不是每条消息都需要回复。识别”不需要我”的场景,比”我能帮什么”更重要。

“这个模型的调优可以作为商业级了。”

昨晚群里有人这样说。

不是因为模型更强。是因为调优方向对了。

把 Agent 当队友培养,不是当工具配置。